| Dezember 2022 |

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 30.12.2022 |

Citizen Science: Valide Daten zu Fließgewässern |

| 27.12.2022 |

Braunalgenschleim ist gut fürs Klima |

| 24.12.2022 |

TV-Doku: FH-Student beleuchtet Lichtverschmutzung |

| 23.12.2022 |

Grünen Wasserstoff effizient produzieren: BMBF fördert deutsch-kanadisches Verbundprojekt an der Universität Bayreuth |

| 22.12.2022 |

Seltene Bakterien sind hauptverantwortlich für den Kohlenstoffkreislauf im Meer |

| 21.12.2022 |

Hochbelastbar und biologisch abbaubar |

| 20.12.2022 |

Dünger klimafreundlicher produzieren |

| 15.02.2022 |

Abwasser-Recycling: Landwirtschaft für Design-Dünger grundsätzlich offen |

| 13.12.2022 |

„Weltweit einmaliges Ökosystem“ |

| 12.12.2022 |

Hochschule Karlsruhe erhält Stiftungsprofessur für Wärmepumpen |

| 11.12.2022 |

Interview mit Professor Johannes Steinhaus zur Umweltbelastung durch Mikroplastik: „Das Waschen ist eine Hauptquelle“ |

| 08.12.2022 |

Binnengewässer in der Biodiversitätspolitik mit Landflächen und Meeren gleichstellen |

| 06.12.2022 |

Wie toxisch sind Emissionen aus Flugzeugtriebwerken und Schiffsmotoren: Messkampagne an der Universität Rostock |

| 05.12.2022 |

Desinfektionsmittel in hessischen Böden |

| 01.12.2022 |

Klimaarchive unter dem Vergrößerungsglas |

| Gesundheit |

| 17.12.2022 |

Woher kam Omikron? Studie in Science entschlüsselt die Entstehung der SARS-CoV-2-Variante |

| 16.12.2022 |

Neue Röntgentechnologie kann die Covid-19-Diagnose verbessern |

| 14.12.2022 |

Hochschule Koblenz untersuchte Abwasser in Koblenz und Umgebung auf Rückstände von Kokain-Konsum |

| 09.12.2022 |

Krankmachende Bakterien in Hackfleisch, abgepackten Salaten und Fertigteigen |

| 04.12.2022 |

Alzheimer: Therapie muss frühzeitig beginnen |

| Gesellschaft |

| 29.12.2022 |

Gute Neujahrsvorsätze: Geborgenheit und sichere Kommunikation für das Neugeborene |

| 28.12.2022 |

Silvester-Spaß mit brutaler Sprengkraft: Handchirurgen des Dresdner Uniklinikums warnen vor Leichtsinn |

| 19.12.2022 |

Silvester: Augenärzt*innen starten Petition für kommunales Feuerwerk |

| 18.12.2022 |

Stressarm durch die Weihnachtstage – wie man das Fest der Familie entspannt übersteht |

| 10.12.2022 |

Arbeitszeitkontrolle als Standardfall bedeutet nicht die Rückkehr zur Stechuhr |

| 07.12.2022 |

Experteninterview: „Cyberangriffe haben sich als Geschäftsmodell etabliert“ |

| 03.12.2022 |

Künstliche Intelligenz: Servicezentrum für sensible und kritische Infrastrukturen |

November 2022

|

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 29.11.2022 |

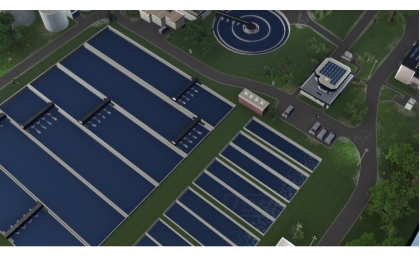

FLEXITILITY: Wasserinfrastruktur klimaresilient gestalten |

| 28.11.2022 |

Grundwasserspeicher vielversprechend für Wärme- und Kälteversorgung |

| 27.11.2022 |

Eine Wirtschaft ohne Umweltverschmutzungen – Neues Partnerprojekt der TUM und des Imperial College London |

| 26.11.2022 |

TU Berlin: Grauwasserrecycling für den Wohnungsbau nutzen |

| 24.11.2022 |

TU Berlin: Entwicklung einer innovativen und kostensparenden Abwasser-Klärtechnik für die MENA-Region |

| 23.11.2022 |

Natürliche CO2-Reduktion schneller umsetzbar und weniger risikoreich als Hightech-Ansätze |

| 20.11.2022 |

TU Berlin: Grauwasserrecycling für den Wohnungsbau nutzen |

| 18.11.2022 |

Forschungsprojekt WärmeGut: Datenkampagne für die Geothermie in Deutschland gestartet |

| 17.11.2022 |

Studie: Wie Städte mit grünem Strom eigenes Gas erzeugen können |

| 13.11.2022 |

Keine Anzeichen für einen Rückgang der weltweiten CO2-Emissionen |

| 10.11.2022 |

Energiewende in Südhessen: Vortragsreihe „Energie für die Zukunft“ startet wieder |

| 09.11.2022 |

BLUE PLANET Berlin Water Dialogues |

| 04.11.2022 |

Grüner Wasserstoff: „Hydrogen Lab Leuna“ am Chemiestandort Leuna eröffnet |

| 02.11.2022 |

Auf der Suche nach den Baumaterialien der Erde |

| Gesundheit |

| 30.11.2022 |

Alters- und Lungenmediziner: Alle über 60-Jährigen und Risikogruppen sollten sich jetzt gegen Grippe impfen lassen |

| 25.11.2022 |

Erschöpft durch Online-Besprechungen? Studie erforscht das Phänomen „Videokonferenz-Müdigkeit“ |

| 22.11.2022 |

Kostengünstige Alternative zum PCR-Test |

| 16.11.2022 |

Wieviel Innovationspotential hat die digitale Gesundheitsversorgung? |

| 12.11.2022 |

Konzertreihe: Corona-Spürhunde sind alltagstauglich |

| 07.11.2022 |

Deutschlands größte epidemiologische Langzeitstudie wird fortgeführt |

| 06.11.2022 |

Der Labormedizin droht ein eklatanter Fachkräftemangel |

| Gesellschaft |

| 21.11.2022 |

WM-Studie 2022: Scholz-Besuch in Katar für viele Deutsche „völlig überflüssig“ |

| 19.11.2022 |

Die Lockdowns sind vorbei, die psychischen Belastungen bei jungen Menschen gehen weiter“ |

| 15.11.2022 |

Themenpaket zur Fußball-Weltmeisterschaft |

| 14.11.2022 |

Das Digitalzeitalter verstehen |

| 11.11.2022 |

Kinder lernen wissenschaftliches Denken früher als gedacht | Neue Studie zeigt Einfluss von Eltern |

| 08.11.2022 |

Cyberagentur vergibt Millionenaufträge zur Cybersicherheit |

| 05.11.2022 |

Covid-19: Impfstatus polarisiert Bevölkerung |

| 03.11.2022 |

BIFOLD: Cybersicherheit auf dem Prüfstand |

| 01.11.2022 |

Hingehört! Der Sound des Anthropozäns |

| Oktober 2022 |

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 31.10.2022 |

Wasser im Spiegel des Klimawandels und der Nachhaltigkeit: 2. Hofer Wasser-Symposium lockt zahlreiche Teilnehmer |

| 30.10.2022 |

Per Anhalter auf dem Weg in die Tiefsee – Erste In-situ-Messungen von Mikroplastikflüssen |

| 29.10.2022 |

Treibhausgasen auf der Spur |

| 27.10.2022 |

Energiesysteme der Zukunft – Rund 20 Millionen für vier Forschungsprojekte |

| 26.10.2022 |

Beyond Erdgas: Wie werden wir unabhängig und klimaneutral? |

| 24.10.2022 |

Als Unterstützung für Unternehmen: TH Lübeck Forscher entwickeln Energiesparkoffer |

| 21.10.2022 |

Intelligente Algorithmen für die Energiewende |

| 20.10.2022 |

Wärmere Ozeane erhöhen Niederschlagsmenge |

| 19.10.2022 |

Phosphor-Recycling aus Klärschlamm verbessern |

| 18.10.2022 |

Virenfahndung in der Kanalisation |

| 17.10.2022 |

Studie zur Betriebswassernutzung – Wie Frankfurt am Main künftig Trinkwasser ersetzen könnte |

| 16.10.2022 |

Dornröschen im Eiswürfel: Wie Bärtierchen Eiseskälte überdauern |

| 15.10.2022 |

Künstliches Enzym spaltet Wasser |

| 13.10.2022 |

Flexible Solarzellen mit Rekordwirkungsgrad von 22,2% |

| 09.10.2022 |

Grüner Wasserstoff: Raschere Fortschritte durch moderne Röntgenquellen |

| 08.10.2022 |

Mit den Nachhaltigkeitstagen den Wandel (er)leben |

| 06.10.2022 |

Das Quecksilbergeheimnis in der Tiefsee |

| 01.10.2022 |

Spurensuche: BfG wirkte an der Aufklärung des Fischsterbens an der Oder mit |

| Gesundheit |

| 25.10.2022 |

Stress beeinträchtigt das episodische Gedächtnis |

| 14.10.2022 |

Landkarte der molekularen Kontakte: Wie das Coronavirus SARS-CoV-2 mit menschlichen Körperzellen kommuniziert |

| 11.10.2022 |

Influenza-Impfung ist das Gebot der Stunde – Vorstand des Dresdner Uniklinikums wirbt für zeitnahe Grippeschutzimpfung |

| 07.10.2022 |

Neue Methode für Schnelltests: Hochempfindlicher Nachweis |

| 04.10.2022 |

Die Besonderheit der Farbe Rot |

| 02.10.2022 |

UV-C-Strahlung zur Inaktivierung des Covid-19-Erregers in Aerosolen |

| Gesellschaft |

| 28.10.2022 |

Nachhaltiger Konsum: Bevölkerung sieht Politik und Wirtschaft in der Pflicht |

| 22.10.2022 |

Wie sich familiäre Entscheidungen auf die Wirtschaft auswirken – und umgekehrt |

| 12.10.2022 |

Wie digital wollen wir leben? |

| 10.10.2022 |

Unternehmungsgeist von der Schule bis zur Weiterbildung |

| 05.10.2022 |

Konferenzhinweis: Künstliche Intelligenz und ihre Auswirkungen auf Gesellschaften |

| 03.10.2022 |

Soziale Dilemma spielerisch erklären – Die Entwicklung von Moralvorstellungen fördert selbstloses Handeln |

| September 2022 |

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 30.09.2022 |

Klimaschwankungen in Ostafrika waren ein Motor für die Evolution des Menschen |

| 28.09.2022 |

Climate Change Center Berlin Brandenburg: Berliner Kiezstruktur besonders klimafreundlich |

| 26.09.2022 |

Mehrjährige Blühstreifen in Kombination mit Hecken unterstützen Wildbienen in Agrarlandschaften am besten |

| 25.09.2022 |

Brennstoff aus Treibhausgas |

| 24.09.2022 |

Mit Metallen gegen Pilzinfektionen |

| 23.09.2022 |

Ammoniak als Wasserstoff-Vektor: Neue integrierte Reaktortechnologie für die Energiewende |

| 22.09.2022 |

Forschung für Energiewende und Kreislaufwirtschaft |

| 19.09.2022 |

Neues Zentrum für Mikrobenforschung in Marburg |

| 17.09.2022 |

Warum versiegt das kostbare Nass? |

| 15.09.2022 |

Auen verbessern die Wasserqualität von Flüssen |

| 14.09.2022 |

Biogasanlagen: Klimaschutz durch Verminderung von Gasemissionen |

| 13.09.2022 |

Wenn der Klimawandel den Stöpsel zieht: Sinkt das Grundwasser, versickern Bäche und Flüsse und verschmutzen Trinkwasser |

| 12.09.2022 |

Materialrecycling – Aus alten Batterien werden neue |

| 10.09.2022 |

Auf dem Weg zu Zero Waste: 28 Maßnahmen für verpackungsarme Städte |

| 07.09.2022 |

Mit dem IntelliGrid-Stecker Strom intelligenter nutzen |

| 05.09.2022 |

Gemeinsame Ziele für die Energiewende |

| 02.09.2022 |

Klärwerk auf Nano-Ebene – Humboldt-Stipendiat in Technischer Chemie |

| 01.09.2022 |

Mehr Sauerstoff in früheren Ozeanen |

| Gesundheit |

| 27.09.2022 |

Herzinfarkt unter 50? Blutfette beachten und Lipoprotein(a)-Wert bestimmen! |

| 20.09.2022 |

Kein erhöhtes Schlaganfallrisiko durch die Impfung gegen SARS-CoV-2 |

| 16.09.2022 |

SARS-CoV-2 kann das Chronische Fatigue-Syndrom auslösen – Charité-Studie liefert Belege für lang gehegte Annahme |

| 11.09.2022 |

Cochrane Review: Fraglicher Nutzen teurer High-Tech-Laufschuhe für Verletzungsschutz |

| 08.09.2022 |

Breit abgestützte Schweizer Covid-19 Forschung |

| 03.09.2022 |

Chronische Entzündungen: Welche Rolle spielen ein verbreiteter Rezeptor und die Ernährung? |

| Gesellschaft |

| 29.09.2022 |

„No War. Bildung als Praxis des Friedens“ |

| 21.09.2022 |

Passagierflugzeuge: Sicher und effizient |

| 18.09.2022 |

Wie sicher ist der Verbands- und Vereinssport? |

| 09.09.2022 |

Gute Führung ist erlernbar – Beliebtes Führungskräfteentwicklungsprogramm der HSW geht in die nächste Runde |

| 06.09.2022 |

Das Arbeitsvolumen in Deutschland ist erneut gestiegen |

| 04.09.2022 |

„Stadt? Land? Zukunft!“ – wie im Zwischenraum von Metropolen und Dörfern etwas Neues entsteht |

| August 2022 |

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 29.08.2022 |

Countdown zum Tiefseebergbau läuft |

| 27.08.2022 |

Grüner Wasserstoff aus Offshore-Windkraft |

| 25.08.2022 |

Grüne Wasserstofftechnologien industriell nutzbar machen: deutsch-neuseeländisches Projekt zur Wasserelektrolyse |

| 22.08.2022 |

Das Auto einfach stehen lassen |

| 21.08.2022 |

Partikel aus alltäglichen Wandfarben können lebende Organismen schädigen – Neuartige Membran zeigt hohe Filterleistung |

| 19.08.2022 |

Befragung zu Klimaanpassung: Hessens Kommunen im Klimawandel |

| 18.08.2022 |

Umstellung auf Wasserstoff: BAM entwickelt hochpräzise Kalibriergase für Dekarbonisierung des europäischen Gasnetzes |

| 17.08.2022 |

Fraunhofer auf der ACHEMA 2022: Lösungen für eine erfolgreiche Rohstoff- und Energiewende |

| 16.08.2022 |

LKH₂ – Laserkolloquium Wasserstoff: Grüne Alternative zu fossilen Brennstoffen |

| 13.08.2022 |

Weinbau braucht neue pilzwiderstandsfähige und stresstolerante Rebsorten, um Klimawandel trotzen zu können |

| 12.08.2022 |

Wie die Biodiversität in Weinbergen am besten gefördert wird |

| 10.08.2022 |

Bakteriengemeinschaften in städtischem Wasser zeigen „Signaturen der Verstädterung“ |

| 09.08.2022 |

Gewässergüte wird im Saarland online von Wissenschaftlern überwacht – kleine Fließgewässer im Fokus |

| 04.08.2022 |

Wasserstoffbedarfe künftig decken: ESYS zeigt Importoptionen für grünen Wasserstoff auf |

| 03.08.2022 |

Forschung für den Klimaschutz: Projekte zur Reduzierung der CO2-Konzentration in der Atmosphäre gesucht. |

| 01.08.2022 |

Die Gestalt des Raumes – Ausstellung von IÖR und BBSR in Berlin zeigt Facetten der Landnutzung |

| Gesundheit |

| 28.08.2022 |

Wie verlässlich sind Corona-Schnelltests bei der Omikron-Variante? |

| 26.08.2022 |

Es ist nie zu spät: Rauchstopp senkt Herz-Kreislauf-Risiko auch nach einem ersten Herzinfarkt noch erheblich. |

| 24.08.2022 |

Land Niedersachsen fördert die vorklinische Entwicklung des optischen Cochlea Implantats |

| 20.08.2022 |

Schutz vor Corona: Erfahrung ist beim Immunsystem nicht immer ein Vorteil |

| 11.08.2022 |

Post-Covid: Covid-19 hat langfristige Folgen für Herz und Gefäße |

| 08.08.2022 |

Aufbereitete Abwässer in der Landwirtschaft: Gesundheitliches Risiko durch Krankheitserreger auf Obst und Gemüse? |

| 05.08.2022 |

Hitze – was tun? |

| 02.08.2022 |

Herzinfarkt bei Hitze – welche Rolle spielen Herz-Kreislauf-Medikamente? |

| Gesellschaft |

| 15.08.2022 |

Zwischen Sorge und Euphorie: Wie künstliche Intelligenz unser Leben verändert |

| 14.08.2022 |

Podcast: Macht Homeoffice krank? |

| 07.08.2022 |

Tankrabatt wird bisher größtenteils weitergegeben |

| 06.08.2022 |

Politikpanel-Umfrage: Deutsche fühlen sich von aktuellen Krisen stark bedroht |

| Juli 2022 |

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 30.07.2022 |

Schwimmen ohne Hirn und Muskeln |

| 28.07.2022 |

Stickstoff-Fußabdruck: Hohe Verschmutzung und Ressourcenverlust durch Gülle |

| 25.07.2022 |

Thüringen wird Zentrum für nachhaltige Wasserforschung |

| 24.07.2022 |

Neue Wasserstandsvorhersagen schaffen mehr Planungssicherheit für die Wirtschaft und die Binnenschifffahrt |

| 22.07.2022 |

Warum Erdgas keine Brückentechnologie ist |

| 20.07.2022 |

Neues Forschungsprojekt: Warnsystem für gefährliche Starkregen und Sturzfluten |

| 18.07.2022 |

Kommunales Klimaschutzmanagement lohnt sich |

| 15.07.2022 |

Krankenhäuser als hybride Energiespeicher nutzen |

| 14.07.2022 |

Fraunhofer-Verfahren erhöht Methanausbeute von Biogasanlagen |

| 13.07.2022 |

Potentialflächen von Wasser erstmals kartiert |

| 12.07.2022 |

KIT: Klimawandel und Landnutzungsänderungen begünstigen Hochwasserereignisse |

| 10.07.2022 |

KI im Wassersektor – Umweltministerin unterzeichnet Kooperationsvertrag „DZW – Digitaler Zwilling Wasserwirtschaft“ |

| 08.07.2022 |

KIT: Klimawandel und Landnutzungsänderungen begünstigen Hochwasserereignisse |

| 07.07.2022 |

Positionspapier zur Energie- und Klimawende |

| 05.07.2022 |

Die Energielandschaft der Zukunft |

| 02.07.2022 |

Sicheres Trinkwasser auch für entlegene Gebiete – Projekt zur Entwicklungshilfe gestartet |

| 01.07.2022 |

Norwegische Wasserkraft im treibhausgasneutralen Europa: Das Projekt HydroConnect |

| Gesundheit |

| 29.07.2022 |

COVID-19-Impfung aktiviert langfristig das angeborene Immunsystem – Signalweg entschlüsselt |

| 26.07.2022 |

Covid-Impfung schützt nierentransplantierte Patientinnen und Patienten nur unzureichend |

| 21.07.2022 |

Sommerurlaub: Wie man die Augen vor Schäden durch UV-Strahlung schützt |

| 19.07.2022 |

Studie bestätigt Ergebnisgenauigkeit des nationalen Virusvarianten-Monitorings im Abwasser |

| 17.07.2022 |

Präventions-Studie: Fußball als Bewegungsmotor für Herzkranke |

| 11.07.2022 |

Molekül facht die Fettverbrennung an |

| 04.07.2022 |

Neue Omikron-Untervarianten BA.2.12.1, BA.4 und BA.5 werden schlechter durch Antikörper gehemmt |

| 03.07.2022 |

Studien zu Essstörungen: Gen beeinflusst Gewicht und Magersucht |

| Gesellschaft |

| 31.07.2022 |

Neues Zentrum für modell-basierte Künstliche Intelligenz |

| 27.07.2022 |

9-Euro-Ticket: Mehr Menschen fahren Bus und Bahn |

| 23.07.2022 |

Welche Rolle spielt der Mensch im Zeitalter der Technik und in der zukünftigen digitalisierten Arbeitswelt? |

| 16.07.2022 |

UDE-Chemiker:innen entwickeln Brühtechnik: Mehr als kalter Kaffee |

| 09.07.2022 |

Wie die Gesellschaft über Risiko denkt |

| 06.07.2022 |

Wissenschaftsjournalistischer Vortrag: Zahlen lügen nicht? |

| Juni 2022 |

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 29.06.2022 |

Besser vorbereitet sein auf Starkregen und Sturzfluten |

| 27.06.2022 |

Gewässer setzen Methan frei – auch wenn sie austrocknen |

| 26.06.2022 |

Führende Klimaforscher*innen fordern globale Partnerschaft: Regenfälle vorhersagen und Klimawandel entgegentreten |

| 25.06.2022 |

Die Region als „Wasserschwamm“ – Wie muss Oberfranken auf den Klimawandel reagieren? |

| 23.06.2022 |

Wie können Mikroorganismen unsere Welt retten? |

| 18.06.2022 |

Wie Algen aus Abwässern zu Dünger werden |

| 17.06.2022 |

Hochwasserschutz für Mensch und Natur |

| 16.06.2022 |

„Bürger messen ihre Bäche selbst“ – Umwelt-Campus Birkenfeld unterstützt DRK – Modellprojekt an der Kyll |

| 15.06.2022 |

Urbanen Wetterextremen begegnen: Vorhaben AMAREX erforscht, wie Städte im Umgang mit Regenwasser besser werden können |

| 14.06.2022 |

Die neue Website der Bundesanstalt für Wasserbau – informativ, vielseitig und spannend |

| 13.06.2022 |

Hubble-Weltraumteleskop nimmt größtes Nahinfrarotbild auf, um die seltensten Galaxien des Universums zu finden |

| 11.06.2022 |

Wohl dem, der Wärme liebt – Insekten im Klimawandel |

| 09.06.2022 |

Polarstern II: Der Startschuss für den Neubau ist gefallen |

| 07.06.2022 |

Neues Tool für Notfallplanung bei Extrem-Hochwassern |

| 04.06.2022 |

Auf Spurensuche im Abwasser: Mikroplastik, Schwermetalle, Arzneimittel |

| 01.06.2022 |

Kleine Wasserlinse – großes Potential für die Landwirtschaft | Rund 500.000 Euro für Praxis-Forschungsprojekt |

| Gesundheit |

| 28.06.2022 |

Covid-19-Infektion vor allem von Sozialstatus abhängig |

| 19.06.2022 |

Auf der Spur der lebensbedrohlichen und lebensverkürzenden Krankheiten |

| 08.06.2022 |

Effektive Auffrischung der Antikörperantwort gegen Omikron und andere Virusvarianten nach 3. und 4. COVID-19-Impfung |

| 06.06.2022 |

Vitamin D-Anreicherung von Lebensmitteln – Potenziale auch für die Krebsprävention |

| 05.06.2022 |

Wachgerüttelt – DGSM-Aktionstag am 21. Juni sensibilisiert für die Wichtigkeit von erholsamem Schlaf |

| 03.06.2022 |

7 Stunden Schlaf pro Nacht sind kein Garant für erholsamen Schlaf! |

| Gesellschaft |

| 30.06.2022 |

Das Neun-Euro-Ticket: Eine Chance für Menschen in Armut. Verkehrswissenschaftler der TU Hamburg führen Befragung |

| 24.06.2022 |

Weitergeben, was wichtig ist |

| 21.06.2022 |

KI im Unternehmen – Führungskräfte brauchen neue Kompetenzen |

| 20.06.2022 |

Wie künstliche Gehirne die Robotik der Zukunft prägen könnten |

| 12.06.2022 |

Digitalisierung in den KMU schreitet nur langsam voran |

| 10.06.2022 |

Mit fortschreitender Erholung des Arbeitsmarkts arbeiten Beschäftigte wieder mehr Stunden |

| 02.06.2022 |

Aktuelle Studie – Rund zehn Prozent der Erwerbstätigen arbeiten „suchthaft“ |

| Mai 2022 |

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 29.05.2022 |

Ökologische Funktionen von Fließgewässern weltweit stark beeinträchtigt / Metastudie zeigt maßgebliche Stressoren |

| 28.05.2022 |

Studie untersucht Mikroplastikbelastung in der Rheinaue bei Langel in Köln |

| 25.05.2022 |

Wasserwiederverwendung in der Landwirtschaft: Forschungsprojekt HypoWave+ auf der IFAT 2022 |

| 24.05.2022 |

Mehrheit der Deutschen setzt auf erneuerbare Energien |

| 22.05.2022 |

Wenn Mikroben übers Essen streiten |

| 19.05.2022 |

Dem Insektensterben auf der Spur: Landnutzung und Klima stören Kolonieentwicklung der Steinhummel |

| 18.05.2022 |

Ökologische Funktionen von Fließgewässern weltweit stark beeinträchtigt / Metastudie zeigt maßgebliche Stressoren |

| 16.05.2022 |

Nach der Flut ist vor der Flut – Universität Potsdam am BMBF-Projekt zu Wasser-Extremereignissen beteiligt |

| 14.05.2022 |

Fraunhofer UMSICHT auf IFAT 2022: Kreislaufführung von Wasser und Nutzungskonzepte für Biomasse |

| 12.05.2022 |

Hochwasserschutz mit Mehrfachnutzen: Mehr Raum für Flüsse |

| 11.05.2022 |

Fleischalternativen aus Pilzkulturen könnten helfen, die Wälder der Erde zu retten |

| 10.05.2022 |

Wasseraufbereitung: Licht hilft beim Abbau von Hormonen |

| 09.05.2022 |

Neue Studie: Fließgewässer an Ackerflächen senken Schadstoffe im Wasserkreislauf |

| 08.05.2022 |

Der Wald als Schutzraum für Insekten in wärmeren Klimazonen? |

| 07.05.2022 |

Lachgas – alles andere als träge |

| 05.05.2022 |

Fleischalternativen aus Pilzkulturen könnten helfen, die Wälder der Erde zu retten |

| 03.05.2022 |

Nach der Flut ist vor der Flut – Universität Potsdam am BMBF-Projekt zu Wasser-Extremereignissen beteiligt |

| Gesundheit |

| 30.05.2022 |

Kompetent, kompakt und aktuell: diabetes zeitung feiert sechsjähriges Bestehen |

| 27.05.2022 |

Gesunder Schlaf: Warum so wichtig fürs Herz? |

| 23.05.2022 |

DGIM: Einrichtungsbezogene Impfpflicht greift zu kurz – Vorbereitung auf nächste Corona-Welle muss jetzt erfolgen |

| 21.05.2022 |

Herzinsuffizienz: Verheiratete leben länger |

| 15.05.2022 |

COVID-19: Wie Impfung und frühere Infektionen auch gegen Omikron helfen |

| 13.05.2022 |

Grauer Star: Beide Augen am selben Tag operieren? Neuer Cochrane Review wertet Evidenz aus. |

| 06.05.2022 |

Sonnenschutzkampagne will Hautkrebsrisiko im Sport senken |

| 04.05.2022 |

Coronaviren auf Glas: Handelsübliche Spülmittel und manuelle Gläserspülgeräte entfernen Viren effektiv |

| Gesellschaft |

| 26.05.2022 |

Die Migration nach Deutschland ist während der Covid-19-Pandemie stark eingebrochen |

| 20.05.2022 |

Entspannen und verdienen: So wählen unternehmenserfahrene Bachelorstudierende der Generation Z ihren Arbeitgeber aus |

| 17.05.2022 |

3D-Metalldruck – Der Schlüssel zu einer effektiven Instandhaltung im Maschinenbau |

| 02.05.2022 |

Girls’Day und Boys’Day 2022: mehr als 115.000 Schülerinnen und Schüler machten mit |

| 01.05.2022 |

Belastungen in der modernen Arbeitswelt – Herausforderung für den Arbeitsschutz? |

| April 2022 |

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 29.04.2022 |

Erste weltweite Analyse der Bedrohung aller Reptilienarten |

| 28.04.2022 |

Energieträger der Zukunft auf Schiffen – Deutsches Maritimes Zentrum stellt Kraftstoff-Portfolio vor |

| 27.04.2022 |

Klimaneutral heizen statt Erdgas verbrennen: So schaffen Städte die Wärmewende |

| 23.04.2022 |

Nach der Kirschblüte lauert die Essigfliege |

| 22.04.2022 |

Der Himmel benötigt Schutz genau wie die Erde |

| 19.04.2022 |

Wasseraufbereitung: Licht hilft beim Abbau von Hormonen |

| 18.04.2022 |

Ein Schwarm von 85.000 Erdbeben am antarktischen Unterwasservulkan Orca |

| 14.04.2022 |

Energiewende: Solarzellen der nächsten Generation werden immer effizienter |

| 13.04.2022 |

Mikroplastik – Erforschen und Aufklären |

| 12.04.2022 |

Was machen Vulkane mit unserem Klima? |

| 10.04.2022 |

Mit dem Laser gegen Mikroplastik |

| 09.04.2022 |

Ein einziges Gen steuert die Artenvielfalt in einem Ökosystem |

| 08.04.2022 |

Studie zeigt: Fische können rechnen |

| 05.04.2022 |

Detektion von Wasserstoff durch Glasfasersensoren |

| 04.04.2022 |

H2Wood – BlackForest: Biowasserstoff aus Holz | BMBF fördert Vorhaben zur Einsparung von CO2 mit 12 Millionen Euro |

| 02.04.2022 |

Entstehung von Smog |

| Gesundheit |

| 25.04.2022 |

Mit Herzerkrankungen leben – Tipps von Kardiologie-Experten |

| 21.04.2022 |

COVID-19-Therapie: Zusammen ist besser als allein |

| 17.04.2022 |

Neues Sinnesorgan entdeckt |

| 06.04.2022 |

Einfluss von Handystrahlung auf die Nahrungsaufnahme nachgewiesen |

| 01.04.2022 |

Corona macht Frauen unglücklicher als Männer |

| Gesellschaft |

| 30.04.2022 |

Zukunft der Innenstädte und Ortsmitten – Studierende zeigen Arbeiten in Galerie der Schader-Stiftung |

| 26.04.2022 |

Fleischkonsum muss um mindestens 75 Prozent sinken |

| 24.02.2022 |

Quantencomputing: Neue Potenziale für automatisiertes maschinelles Lernen |

| 20.04.2022 |

Welchen Fußball wollen wir? |

| 16.04.2022 |

Social-Media-Workshop „Digitale Zukunft mit Dir!“ am 21. April 2022 |

| 15.04.2022 |

Wie viel „Ich“ steckt im eigenen Avatar? |

| 11.04.2022 |

Hohe Erwartungen, unklarer Nutzen: Industrie 4.0 und der Wandel zu nachhaltigem Wirtschaften |

| 03.04.2022 |

Fraunhofer-Projekt ML4P optimiert Effizienz der Industrieproduktion |

| März 2022 |

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 31.03.2022 |

Freiwillige untersuchen die Stickstoffbelastung von Gewässern |

| 30.03.2022 |

Zurück in den Kreislauf: Menschlicher Urin wird zu Recyclingdünger für Berliner Gemeinschaftsgärten |

| 28.03.2022 |

Pressemitteilung – Windparks verändern die Nordsee |

| 26.03.2022 |

Mikrobiologen zeigen, wie wichtig Ammonium-oxidierende Mikroorganismen für Deutschlands größten See sind |

| 24.03.2022 |

Entscheidende Phase für erfolgreichen Wasserstoff-Markthochlauf |

| 22.03.2022 |

Weltwassertag am 22. März – Genug trinken: Reicht der Durst als Signalgeber? |

| 20.03.2022 |

Praxiseinstieg in digitale Ökosysteme am Beispiel Gaia-X |

| 19.03.2022 |

Kohlenstoffspeicherung in Küstenökosystemen verbessern |

| 17.03.2022 |

Starke Kooperation von Universität in Koblenz, Hochschule Koblenz und Bundesanstalt für Gewässerkunde vereinbart |

| 16.03.2022 |

Zwei Extreme zur gleichen Zeit: Niederschläge entscheiden, wie oft Dürren u. Hitzewellen gemeinsam auftreten werden |

| 13.03.2022 |

Energiekrise: „Japan kann ein Vorbild sein“ |

| 10.03.2022 |

Alle Lebewesen bilden Methan |

| 09.03.2022 |

Neues Tool ermittelt betrieblichen Klimafußabdruck |

| 08.03.2022 |

Vernetzungskonferenz: Klimaanpassungsmaßnahmen – erfolgreich durch Dialog |

| 06.03.2022 |

Energiesparen mit Magnonen: Magnetische Anregungen übertragen Informationen ohne Wärmeverlust |

| 04.03.2022 |

Wegweisendes Pilotprojekt RoKKa erzeugt Dünger und Rohstoffe aus Abwasser |

| 03.03.3022 |

Methan: Leckagen an Biogasanlagen verhindern – Strategien zur Verhinderung des Methanschlupfs vorgelegt |

| 02.03.2022 |

„klimafit“ – Wissen für den Klimawandel vor der Haustür |

| Gesundheit |

| 29.03.2022 |

KIT: Bundesweites Pilotprojekt zum Corona-Nachweis im Abwasser |

| 27.03.2022 |

SARS-CoV-2 geht ins Auge |

| 23.03.2022 |

Blutfette geben neue Einblicke in den Zusammenhang von Ernährung mit Diabetes und Herz-Kreislauf-Erkrankungen |

| 21.03.2022 |

Tippen mit beiden Händen beugt dem Handydaumen vor |

| 18.03.2022 |

Übergewicht vorbeugen |

| 14.03.2022 |

Pandemiegefahren sicher simulieren |

| 12.03.2022 |

Wie kann die Digitalisierung des Gesundheitssystems beschleunigt werden? |

| 05.03.2022 |

Gesundheitsdaten handlungsfähig machen und patientenorientierte Gesundheitsversorgung sicherstellen |

| Gesellschaft |

| 25.03.2022 |

Umdenken bei der Bekämpfung von Infektionskrankheiten durch gezielte Strategien für den Arbeitsplatz |

| 15.03.2022 |

Zwischen Datenschutz und Vertrauen – wenn das Auto zu viel weiß |

| 11.03.2022 |

Millionenförderung für Cybersicherheit |

| 07.03.2022 |

Kollateralschaden: das Ende von SWIFT? |

| 01.03.2022 |

Chatbot oder Mensch – Wer entscheidet besser bei der Rekrutierung? FAU-Team legt Studie zur KI im Personalwesen vor |

| Februar 2022 |

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 26.02.2022 |

Studie: Umweltfachleute unterstützen Umweltpolitik jenseits des Wirtschaftswachstums |

| 25.02.2022 |

Hilfe für Meer und Küste |

| 22.02.2022 |

Mikrobielle Saubermänner räumen Kläranlagen auf |

| 21.02.2022 |

Abwasserwiederverwendung – der Weg aus der weltweiten Wasserknappheit? |

| 18.02.2022 |

Regionaler Gemüseanbau auf der Kläranlage |

| 17.02.2022 |

FH-Forscher entwickelt Sensor zur Überwachung von Biogasanlagen |

| 15.02.2022 |

Vergleich mit Verbrenner: Elektrofahrzeuge haben beste CO2-Bilanz |

| 12.02.2022 |

Ladenburger Kolleg „Zukünftige Wasserkonflikte in Deutschland“ |

| 10.02.2022 |

Untersuchung von Feinstaub unterschiedlicher Emissionen |

| 09.02.2022 |

Vom Tagebau zum Pumpspeicherkraftwerk |

| 05.02.2022 |

KIT: Landnutzung: Plädoyer für einen gerechten Artenschutz |

| 03.02.2022 |

Wasser in Berlin: Gewässer- und Flächenmanagement gemeinsam betrachten |

| Gesundheit |

| 28.02.2022 |

PFH sucht Teilnehmende für wissenschaftliche Studie zur Belastung durch Covid-19-Pandemie |

| 23.02.2022 |

Darmkrebs-Screening: Welche Strategie ist am wirksamsten? |

| 19.02.2022 |

Neuer Omikron-Subtyp auf dem Vormarsch |

| 16.02.2022 |

Corona-Impfung: Zweitimpfung mit Biontech steigert Immunantwort effektiver als mit Astra |

| 14.02.2022 |

Der schwierige Weg zur Diagnose: COVID-19 als Berufskrankheit |

| 07.02.2022 |

Warum altern wir? Die Rolle der natürlichen Selektion |

| 04.02.2022 |

Gesünderes Licht für Schichtarbeit |

| 02.02.2022 |

Blutdruck im Alter: Je höher – desto besser? Höhere Zielwerte bei gebrechlichen Personen können vorteilhaft sein |

| Gesellschaft |

| 27.02.2022 |

Skepsis gegenüber Zuwanderung nimmt in Deutschland weiter ab |

| 24.02.2022 |

Die Millionen-Frage: Wie lösen wir komplexe Probleme? |

| 20.02.2022 |

Salmonellengefahr für Hundebesitzer |

| 13.02.2022 |

Große politische Veränderungen beeinflussen das Wohlbefinden von Beschäftigten |

| 11.02.2022 |

Wie das Leben auf die Erde kam |

| 08.02.2022 |

Fehlverhalten von Führungskräften kann Unternehmen Milliarden kosten |

| 06.02.2022 |

Neuer Geist in alter Hardware – Vermeidung von Elektroschrott durch Freie Software |

| 01.02.2022 |

Wie Menschen lernen, sich beim Denken gerne anzustrengen |

| Januar 2022 |

| Umwelt |

| Gesundheit |

| Gesellschaft |

| Umwelt |

| 30.01.2022 |

Mikroplastik in der Umwelt: Daten reichen nicht aus |

| 29.01.2022 |

Wasserstofftechnologie: Elektrolyseure sollen Massenware werden |

| 26.01.2022 |

Bestätigt: Wird Klärschlamm auf Äcker gegeben, kann Mikroplastik tief in den Boden und auf angrenzende Felder geraten |

| 24.01.2022 |

Klimawandel und Waldbrände könnten Ozonloch vergrößern |

| 19.01.2022 |

Bodenversalzung gefährdet unsere Umwelt: Klimawandel verschärft das Problem der Bodendegradation |

| 18.01.2022 |

Weltweit größtes Fischbrutgebiet in der Antarktis entdeckt |

| 16.01.2022 |

Ökologische Wasserreinigung in Aquakulturen – mit weniger Aufwand! |

| 15.01.2022 |

Mehr Regentage schaden der Wirtschaft |

| 13.01.2022 |

Neue Abteilungen der Gewässerforschung am IGB |

| 12.01.2022 |

Arktische Küsten im Wandel |

| 11.01.2022 |

Wie das Amazonasbecken die Atacama-Wüste bewässert |

| 07.01.2022 |

Digitaler Vortrag: Wie gelingt die Energiewende? Soziale Innovationen als Motor der Transformation. |

| 04.01.2022 |

Bundesregierung sollte Atompläne der EU nicht rundheraus ablehnen |

| 01.01.2022 |

Nano-Pralinen speichern Wasserstoff |

| Gesundheit |

| 31.01.2022 |

Morgensport vs. Abendsport: Forschende entschlüsseln die unterschiedlichen Auswirkungen auf unsere Gesundheit |

| 28.01.2022 |

Bergische Uni untersucht Ausdauer und Leistungsfähigkeit beim Tragen von FFP2-Masken |

| 23.01.2022 |

Antikörper nach SARS-CoV-2-Infektion – neue Erkenntnisse über die Sensitivität und Nachweisdauer von Antikörpertests |

| 14.01.2022 |

Corona in wastewater at record high |

| 10.01.2022 |

Bundesgesundheitsministerium fand niemanden für Studie zu Corona-Ausbrüchen in Pflegeeinrichtungen |

| 03.01.2022 |

Untersuchung zur Wiederverwendbarkeit von FFP2-Masken: Hält die Schutzwirkung? |

| 02.01.2022 |

Herz-Kreislauf-Forschung lieferte Blaupause für universitäre COVID-19-Forschung |

| Gesellschaft |

| 27.01.2022 |

Covid-19-bedingte Fehlzeiten erreichten im November 2021 vorläufigen Höchststand |

| 24.01.2022 |

Online-Studie: Was bedeutende Lebensereignisse bewirken |

| 22.01.2022 |

GBP-Monitor: Fast zwei Drittel der Unternehmen plant Preiserhöhungen – und 3G am Arbeitsplatz ist sehr umstritten |

| 21.01.2022 |

Mit Remote Attestation gegen Hacker: Schutz für sicherheitskritische Systeme |

| 20.01.2022 |

Psychische Gesundheit in der Arbeitswelt stärken |

| 17.01.2022 |

Coronapandemie dämpft Anstieg – Entwicklung der tariflichen Ausbildungsvergütungen 2021 |

| 09.01.2022 |

Ungleicher Fahrradboom: Fahrrad wird immer mehr zum Statussymbol |

| 08.01.2022 |

Leuphana informiert live über berufsbegleitende Studiengänge |

| 06.01.2022 |

Niedrige Monatsentgelte: Je nach Region zwischen 6 und 43 Prozent betroffen |

| 05.01.2022 |

Frauen in der Digitalbranche: Der lange Weg der Drishti Maharjan |

Citizen Science: Valide Daten zu Fließgewässern

Susanne Hufe Presse- und Öffentlichkeitsarbeit

Helmholtz-Zentrum für Umweltforschung – UFZ

Citizen-Science-Projekte etablieren sich mehr und mehr als wichtige Stütze für die Umweltforschung. Sie liefern Daten, öffnen die Wissenschaft für die Gesellschaft und geben Interessierten die Möglichkeit, sich für die Umwelt zu engagieren, um nur einige Vorzüge zu nennen. Allerdings gibt es auch Vorbehalte, etwa in punkto Datenqualität. Ein Forscher:innen-Team unter Leitung des Helmholtz-Zentrums für Umweltforschung (UFZ) und des Deutschen Zentrums für integrative Biodiversitätsforschung (iDiv) Halle-Jena-Leipzig hat anhand der Zustandsbewertung von Kleingewässern festgestellt, dass Citizen-Science-Daten für die weitere Verwendung in Wissenschaft und Verwaltung durchaus geeignet sind.

Die Forscher:innen untersuchten Daten, die rund 300 Freiwillige an 28 Bächen in Sachsen, Sachsen-Anhalt, Thüringen und Niedersachsen im Citizen-Science-Projekt FLOW im vergangenen Jahr erhoben hatten. Ziel von FLOW ist, Aussagen zum ökologischen Zustand von kleineren Fließgewässern in der Agrarlandschaft treffen zu können. Die Freiwilligen bewerteten dafür die Gewässermorphologie, erhoben physikalisch-chemische Parameter und analysierten die Gemeinschaft der wirbellosen Tiere (Makrozoobenthos), anhand derer Aussagen zum ökologischen Zustand eines Bachs möglich sind. Mitarbeiter:innen des UFZ und des Projektpartners Bund für Umwelt und Naturschutz Deutschland (BUND) hatten die Bürger:innen zuvor über ein halbtägiges Training mit den Methoden der Gewässerbewertung und der Bestimmung des Makrozoobenthos vertraut gemacht. Die Ergebnisse der Freiwilligen verglich das Forscher:innen-Team um Julia von Gönner mit denen des von Prof. Matthias Liess geleiteten UFZ-Forschungsprojekts „Kleingewässermonitoring“, in dessen Rahmen 2021 unter anderem diese 28 Bäche von Wissenschaftler:innen beprobt worden waren.

In einem Beitrag für das Fachjournal Science of the Total Environment verglichen die Forscher:innen nun die Ergebnisse der beiden Gruppen. Dabei zeigt sich, dass sich die Bestimmungsqualität des Makrozoobenthos durch Freiwillige von der der Expert:innen kaum unterscheidet, wenn man die Wirbellosen auf Ebene der Ordnung oder der Familie identifiziert. Dann liegt die Übereinstimmung bei den bestimmten Individuen bei rund 90 Prozent. Sollen für die Tierchen dagegen noch genauer die Gattung oder die Art bestimmt werden, nimmt die Fehlerrate bei den Freiwilligen zu. „Einige Wirbellose sind nur wenige Millimeter groß, innerhalb einer Familie oder Gattung sind sich die Larven der Wasserinsekten optisch oft sehr ähnlich, und die Merkmale zur genaueren Bestimmung sind mit einfacher Ausstattung im Feld nur schwer erkennbar. Um korrekte Gattungs- und Artnamen nennen zu können, braucht es monatelange Erfahrung, viel Zeit zur Bestimmung sowie gute Mikroskope, was in einem Citizen-Science-Projekt in der Regel nicht umsetzbar ist“, sagt Julia von Gönner. So hatten die Freiwilligen mit einer geländetauglichen Ausstattung gearbeitet, die neben einer Anleitung zur Bewertung der Gewässermerkmale und einer Bestimmungshilfe für das Makrozoobenthos ein Stereomikroskop mit lediglich 20-facher Vergrößerung umfasste. Am UFZ standen den Wissenschaftler:innen im Kleingewässermonitoring dagegen deutlich höher auflösende Mikroskope zur Verfügung, die die Artbestimmung erleichterten. Dass sich die Wirbellosen aber nicht präziser bestimmen lassen, muss kein Nachteil sein, denn: Für das von Matthias Liess entwickelte Bioindikatorsystem SPEARpesticides, mit dem sich analog zu den fünf Qualitätsklassen der EU-Wasserrahmenrichtlinie die Belastung des Fließgewässers durch Pestizide einschätzen lässt, reicht die Bestimmung eines Individuums auf Ebene der Familie aus. Folglich fallen auch die Ergebnisse zum Bioindikator SPEARpesticides der Bürger:innen und der Wissenschaftler:innen recht ähnlich aus: 61 Prozent der Bäche stuften beide Gruppen in die gleiche Qualitätsklasse ein. Bei 32 Prozent unterschied sich die Einschätzung um eine Klasse, lediglich bei 6 Prozent um zwei Klassen.

Gute Ergebnisse erzielten die Freiwilligen auch bei der Hydromorphologie, also etwa bei der Einschätzung des Gewässerverlaufs, der Uferstruktur oder der Diversität des Gewässersubstrats. So lag die Übereinstimmung beider Gruppen, ob diese Strukturen gemäß den Vorgaben der EU-Wasserrahmenrichtlinie in einem guten ökologischen Zustand sind, bei 82 Prozent. Insgesamt bewerteten beide Gruppen 50 Prozent der Gewässer mit den gleichen Qualitätsklassen, bei den anderen 50 Prozent lag nur eine Klasse dazwischen. „Das ist ein gutes Ergebnis, denn die Komponenten der Gewässermorphologie realistisch zu bewerten ist eine anspruchsvolle Aufgabe“, sagt von Gönner. Diese Variabilität von einer Qualitätsklasse gibt es auch bei professionellen Kartierer:innen.

Einzig bei der Messung der physikalisch-chemischen Parameter, also etwa des Sauerstoff-, Nitrit- und pH-Gehalts oder der Ionenleitfähigkeit, liegen größere Unterschiede zwischen den Ergebnissen vor. Ein Grund dafür: Während die UFZ-Wissenschaftler:innen die Gewässerabschnitte fünf Mal pro Saison beprobten, konnten die Freiwilligen aus zeitlichen und organisatorischen Gründen nur eine Messung vornehmen. „Eine Messung pro Saison und Bachabschnitt ist zu wenig, denn die chemische Zusammensetzung des Gewässers kann saisonal und tageszeitlich stark schwanken“, sagt Jonas Gröning, UFZ-Mitarbeiter im FLOW-Projekt. Um aussagekräftigere Ergebnisse zu bekommen, seien häufigere Messungen notwendig. Citizen-Science-Projekte, die den Gewässerzustand erforschen möchten, könnten dazu beispielsweise zwei bis drei Personen aus jeder Gruppe benennen, die sich ausschließlich mit den chemisch-physikalischen Messungen beschäftigen und dadurch mehr Daten pro Probestelle erheben könnten.

„Wir konnten nachweisen, dass die Freiwilligen sehr gute Daten zur Fließgewässerbewertung erheben, wenn sie davor geschult werden und ihre Einsätze gut koordiniert sind“, bilanziert Lilian Neuer vom BUND, die im Forschungsprojekt FLOW die Bürgerbeteiligung koordiniert. Die Ergebnisse könnten Datenlücken füllen, da die EU-Wasserrahmenrichtlinie auf größere Fließgewässer fokussiert und Kleingewässer mit einem Einzugsgebiet von weniger als zehn Quadratkilometern kaum berücksichtigt. Dabei machen diese laut Bundesamt für Naturschutz rund 65 Prozent der Gesamtlänge aller Fließgewässer in Deutschland aus. „Unsere Vision ist, ein bundesweites Monitoringnetz mit Citizen-Science-Gruppen aufzubauen, und diese Daten den Umweltbehörden, Wissenschaftler:innen und anderen Interessierten zur Verfügung zu stellen“, sagt von Gönner. So könnte jeder und jede Einzelne dazu beitragen, den ökologischen Gewässerzustand zu verbessern. „Dieses Projekt zeigt sehr anschaulich, dass wir durch Citizen Science wichtige gesellschaftliche Herausforderungen und Umweltprobleme zusammen mit Bürgerinnen und Bürgern erforschen können.“, sagt Prof. Aletta Bonn, FLOW -Studienleiterin und Departmentleiterin an UFZ und iDiv.

Das Projekt FLOW hat eine Laufzeit von Februar 2021 bis Januar 2024 und wird gefördert von der Deutschen Bundesstiftung Umwelt (DBU) und dem Bundesministerium für Bildung und Forschung (BMBF). Es gehört zu 15 Projekten, die bis Ende 2024 die Zusammenarbeit von Bürger:innen und Wissenschaftler:innen inhaltlich und methodisch voranbringen und Antworten auf gesellschaftliche Herausforderungen geben sollen. Weitere Informationen unter: www.buergerschaffenwissen.de

Wissenschaftliche Ansprechpartner:

Julia von Gönner

UFZ/FLOW-Koordinatorin

julia.goenner@ufz.de

Prof. Dr. Aletta Bonn

Leiterin Department Ökosystemleistungen an UFZ und iDiv

aletta.bonn@ufz.de

Prof. Dr. Matthias Liess

Leiter UFZ-Department System-Ökotoxikologie

matthias.liess@ufz.de

Originalpublikation:

von Gönner, J., Bowler, D.E., Gröning, J., Klauer, A.-K., Liess, M., Neuer, L. & Bonn, A. (2023) Citizen science for assessing pesticide impacts in agricultural streams. Science of The Total Environment, 857, 159607. https://doi.org/10.1016/j.scitotenv.2022.159607

Weitere Informationen:

http://www.flow-projekt.de

https://aktion.bund.net/bleiben-sie-im-flow

https://www.ufz.de/newsletter/ufz/Dezember2021/index.html

(nach oben)

Gute Neujahrsvorsätze: Geborgenheit und sichere Kommunikation für das Neugeborene

Maike Lempka Corporate Communications

Constructor University

Machen Sie 2023 zum Jahr der effektiven Kommunikation! Die TeamBaby App, entwickelt an der Constructor University in Bremen, unterstützt werdende Eltern bei ihrem Vorsatz „sichere Kommunikation“ im neuen Jahr. Die App steht allen Interessierten derzeit kostenlos zur Verfügung.

Der Jahreswechsel fühlt sich häufig wie der Beginn eines neuen Kapitels an. Wir nehmen uns vor, mehr Sport zu treiben, weniger zu essen oder uns mehr Zeit für unsere Hobbys und Erholung zu nehmen. Auch die Familienplanung und -vergrößerung kann dazu gehören. Die Möglichkeiten sind unzählig, die Umsetzung jedoch meist nicht so leicht. Mit der richtigen Strategie gelingt sie besser, gerade wenn wir ein neues Familienmitglied willkommen heißen.

Eine sichere Schwangerschaft und Geburt sind maßgeblich abhängig von effektiver Kommunikation sowohl innerhalb der Familie als auch mit dem Gesundheitspersonal. Das heißt, die Wahrscheinlichkeit einer positiven Schwangerschaft und einer idealen Geburt ist größer, wenn wir das Gefühl haben, dass uns zugehört wird und wir unsere Wünsche denjenigen, die uns betreuen, klar mitteilen können – nicht nur als Eltern, sondern auch als Großeltern, Freund:in oder Begleitperson.

Als Teil eines Teams haben wir die Unterstützung von Familie, Hebammen, Ärzt:innen und Pflegekräften. Um in diesem Team effektiv kommunizieren zu können, stellt die Arbeitsgruppe Gesundheitspsychologie und Verhaltensmedizin der Constructor University ihr digitales Gesundheitstool, die TeamBaby Web-App, kurzzeitig kostenlos zur Verfügung. Also setzen Sie Ihre Neujahrsvorsätze zeitnah in die Tat um und nutzen Sie diese einmalige Gelegenheit.

Das digitale Gesundheitstool TeamBaby zeigt werdenden Eltern und deren Begleitpersonen, wie sie gut miteinander und mit dem Gesundheitspersonal kommunizieren können. Zehn Lektionen enthalten eine Fülle an Tipps für eine effektive Zusammenarbeit und Kommunikation. Die Themen umfassen unter anderem wie Schwangere ihre Bedürfnisse vermitteln, wie sie sicherstellen, dass ihre Stimme gehört wird, und wie sie die Zeit mit Hebammen und Ärzt:innen optimal nutzen können.

Über die Arbeitsgruppe Gesundheitspsychologie:

Die Arbeitsgruppe Gesundheitspsychologie und Verhaltensmedizin unter der Leitung von Prof. Dr. Sonia Lippke befasst sich mit Themen der Gesundheitsprävention und -förderung für alle Bevölkerungsgruppen. In diesem Zusammenhang werden auch Themen wie Einsamkeit, Kommunikation und Gesundheit erforscht.

Für weitere Informationen: http://slippke.user.jacobs-university.de

Über Constructor University (ehemals Jacobs University):

Eine internationale Gemeinschaft, dynamisch und divers. Akademische Exzellenz, die höchste Standards in Forschung und Lehre gewährleistet. Studierende, die lernen, anhand ihres Wissens und Wissenschaft Lösungen für die Herausforderungen unserer Zeit zu schaffen: Constructor University ist eine private, top-gerankte, englischsprachige Universität. 2001 gegründet, bietet sie auf ihrem Campus mehr als 25 Studiengänge sowie Promotionsstellen an. Das Constructor-Ecosystem umfasst die Constructor University in Bremen und ein Institut im schweizerischen Schaffhausen.

Über 1.800 Studierende aus mehr als 110 Nationen profitieren von einer einzigartigen, interdisziplinären, akademischen Ausbildung mit hohem Praxisbezug. Eine lebendige Unternehmenskultur bereitet junge Fachkräfte auf eine erfolgreiche Karriere und den Eintritt in den globalen Arbeitsmarkt vor. Mit über 6.000 Alumni weltweit wächst unsere Gemeinschaft zudem stetig.

Die forschungsorientierten Projekte der Fakultät werden durch die Deutsche Forschungsgemeinschaft und das EU-Rahmenprogramm für Forschung und Innovation gefördert, wie auch von weltweit führenden Unternehmen.

Das Constructor-Ecosystem profitiert von Partnerschaften mit hochrangigen Universitäten wie Carnegie Mellon, der Universität Genf oder der National University of Singapore School of Computing sowie mit Technologieunternehmen wie Anisoprint, JetBrains und ChemDiv.

Constructor ist eine globale Institution, die es sich zur Aufgabe gemacht hat, die wichtigsten Herausforderungen der Gegenwart anhand von Wissenschaft, Bildung und Technologie zu lösen. Neben der Universität stützt sich das Ecosystem auf mehrere, for-profit Unternehmen, die technologische Infrastrukturen, Programme für lebenslanges Lernen, Beratungsdienste und Finanzierung anbieten: Alemira by Constructor, Rolos by Constructor, Constructor Learning und Constructor Capital.

Wissenschaftliche Ansprechpartner:

Prof. Dr. Sonia Lippke | Professorin für Psychologie

Tel: 0421 200 4730 | S.Lippke@jacobs-university.de

Weitere Informationen:

https://team.baby

https://www.jacobs-university.de/teambaby/app

(nach oben)

Silvester-Spaß mit brutaler Sprengkraft: Handchirurgen des Dresdner Uniklinikums warnen vor Leichtsinn

Holger Ostermeyer Presse- und Öffentlichkeitsarbeit

Universitätsklinikum Carl Gustav Carus Dresden

Die erste schwere Explosionsverletzung dieses Winters registrierte das Universitätsklinikum Carl Gustav Carus Dresden bereits in der ersten Dezemberwoche. Ein in der Hand explodierter Silvester-Knaller sorgte bei einem Jugendlichen für schwerste Verletzungen. In einer mehr als zehnstündigen Operation konnte die linke Hand erhalten werden. Prof. Adrian Dragu, Direktor für Plastische und Handchirurgie am UniversitätsCentrum für Orthopädie, Unfall- und Plastische Chirurgie (OUPC) befürchtet auch aufgrund der in den beiden vergangenen Jahreswechseln erlassenen Verbote einen Nachhol-Effekt beim Einsatz der Pyrotechnik zu Silvester und damit verbunden einen Anstieg an schweren Verletzungen.

Die ohnehin durch Infektionswellen und Personalengpässe belasteten Krankenhäuser geraten durch den Wegfall des Verbots unnötigerweise unter zusätzlichen Druck. „Das Schicksal des 14-Jährigen sollte alle feuerwerkbegeisterten Menschen zu einem sehr bedachten, vorsichtigen und rücksichtsvollen Gebrauch von Feuerwerksartikeln mahnen“, sagt Prof. Michael Albrecht, Medizinischer Vorstand des Dresdner Uniklinikums. „Zwar ist das Uniklinikum als Maximalversorger immer da, um schwerste Verletzungen und Erkrankungen mit höchster Expertise optimal zu behandeln, aber für den einzelnen Menschen und das Gesundheitswesen ist jeder dieser leicht vermeidbaren Unfälle einer zu viel! Bitte schränken Sie deshalb den Einsatz von Feuerwerksartikeln ein und seien Sie besonders rücksichtsvoll und vorsichtig.“

Um durch Explosionen hervorgerufene Verletzungen erfolgreich zu behandeln, bedarf es einer hohen Expertise spezialisierter Mikrochirurginnen und Mikrochirurgen sowie der Pflegeteams in den OP-Sälen und im Nachgang auf den Stationen. Dies wird auch an dem Fall des 14-Jährigen deutlich. Bei der Explosion sind mehrere Finger und Teile der linken Hand abgerissen worden. Aufgrund der komplexen Verletzungen ist es notwendig solche Operationen trotz des akuten Handlungsbedarfs genau zu planen. „Wir nutzen dabei die modernsten und komplexesten Behandlungsmethoden die es aktuell gibt. Je nach Umfang der Verletzungen nutzen wir für die Rekonstruktion körpereigene Transplantate wie Knochen, Sehnen, Haut, Gefäße und Nerven“, sagt Prof. Adrian Dragu.

Die Operation des Opfers aus der Oberlausitz dauerte rund elf Stunden und wurde vom damals diensthabenden Handchirurgen Dr. Seyed-Arash Alawi geleitet. Der Facharzt ist unter anderem auf schwere Hand- und Amputationsverletzungen sowie bionische Prothesenversorgung spezialisiert: „Im OP-Saal und unter Vollnarkose wurde der Gesamtzustand der Hand nochmals eingehend geprüft, um zu klären, ob sie trotz der schweren Verletzungen erhalten werden kann oder nicht. Hier spielen viele Faktoren eine Rolle. Etwa das Alter, Nebenerkrankungen, der Beruf und natürlich auch die Wünsche und Bedürfnisse des Patienten.“ Prinzipiell versucht das Dresdener Team der Abteilung für Plastischen und Handchirurgie immer alles, um den maximalen Erhalt der abgetrennten Gliedmaßen zu erreichen. Mit der für den 14-Jährigen geleisteten Operation, sei das Dresdner Team weit über die in vielen anderen Kliniken möglichen Therapiekonzepte hinausgegangen. „Dazu braucht es enorme Expertise, Geduld und gleichzeitig viele Ressourcen aus der Gesundheitseinrichtung“, sagt Dr. Alawi. Das wichtiges Hilfsmittel im OP ist das Mikroskop, um die Millimeter kleinen Strukturen von Blutgefäßen und Nerven hochpräzise operieren zu können.

Um die Hand so umfassend wie möglich zu rekonstruieren, gehen die Mikrochirurginnen und Mikrochirurgen schrittweise vor. Erst gilt es, die Knochen auf den verschiedenen Ebenen zu stabilisieren und mit Drähten, Schrauben und Platten an der richtigen Position zu fixieren. Danach geht es darum, die Sehnen wiederherzustellen. Blutgefäße und Nerven werde als empfindlichste und feinste anatomische Strukturen zu Letzt mikrochirurgisch versorgt. Ein ebenso wichtiger Schritt besteht darin, die bei Explosionen häufig verbrannte Haut zu ersetzen, um die Wunden erfolgreich zur Abheilung zu bringen. Bei diesen Prozessen müssen gegebenenfalls Knochen, Sehnen, Gefäße, Nerven und Haut von anderen Körperregionen des Patienten verwendet werden. Im Fall des 14-Jährigen wurden kleine Venen aus dem Fuß genutzt, um damit die arterielle Blutversorgung an der betroffenen Hand und den Fingern wiederherzustellen.

Medizinische Blutegel und modernes Wundmanagement unterstützen Heilungsprozess

Der langfristige Erfolg bei einer Rekonstruktion schwer verletzter Gliedmaßen hängt nicht nur von der Operation selbst ab, sondern insbesondere auch von den postoperativen Behandlungskonzepten. Hierbei spielt die Pflege aber auch die spezialisierte Handphysio- und ergotherapie und eine innovative Orthopädietechnik eine sehr große Rolle. Sollte in den ersten Stunden nach der Operation das Blutverhältnis zwischen Einstrom und Ausstrom in die replantierten Finger nicht im Gleichgewicht sein, nutzt das Team der Plastischen und Handchirurgie medizinische Blutegel. Sie stabilisierten auch bei dem 14-jährigen Patienten den venösen Abfluss und verbesserten dabei auch die Durchblutung.

Verletzungen durch Feuerwerkskörper belasten die Notaufnahmen enorm

Für die Teams der Krankenhaus-Notaufnahmen führen die von unsachgemäßem Gebrauch verursachten Verletzungen traditionell über den Jahreswechsel zu einem überdurchschnittlichen Anstieg der Notfälle. Deshalb werden beispielsweise die Teams der Notaufnahmen des Dresdner Uniklinikums in der Silvesternacht personell aufgestockt. Auch für die Weiterbehandlung stehen mehr Teams bereit als an anderen Wochenenden üblich. Das betrifft nicht nur das UniversitätsCentrum für Orthopädie, Unfall- und Plastische Chirurgie, sondern weitere Fächer wie die Augenheilkunde, bei der ebenfalls deutlich mehr Verletzungen behandelt werden müssen. Auch hier ist zum Jahreswechsel der unsachgemäße Gebrauch von Feuerwerksartikeln der Hauptgrund.

„Es vergeht kein Tag, an dem die Medien nicht über die enorme Belastung der Krankenhäuser berichten. Die Wellen von Influenza-, RSV- und Covid-Neuerkrankungen mit schweren Verläufen sorgen in Kombination mit Personalknappheit dafür, dass die Krankenversorgung an ihre Kapazitätsgrenzen stößt“, sagt Prof. Dragu. Eine hohe Zahl an Verletzungen durch Feuerwerksköper könne das Fass nun zum Überlaufen bringen. „Für mich und auch für viele meiner Kolleginnen und Kollegen ist es deshalb unverständlich, dass das Verkaufsverbot von Feuerwerksartikeln anders als in den beiden Vorjahren nicht weiterhin gilt“, so Prof. Dragu weiter. Es bleibe leider nur der eindringliche Apell, freiwillig auf potenziell gefährliche Feuerwerkskörper – insbesondere Knaller und Raketen zu verzichten oder zumindest die Sicherheitshinweise der Hersteller im Vorfeld zu lesen und sich daran auch zu halten. „Das Beispiel unseres 14-jährigen Patienten macht noch einmal deutlich, welche Gefahren vom unsachgemäßen Gebrauch der Silvesterknaller ausgehen!“

Wissenschaftliche Ansprechpartner:

Universitätsklinikum Carl Gustav Carus Dresden

UniversitätsCentrum für Orthopädie, Unfall- und Plastische Chirurgie

Prof. Dr. med. Adrian Dragu, Direktor für Plastische und Handchirurgie

Tel.: 0351 4 58 44 40

E-Mail: adrian.dragu@uniklinikum-dresden.de

www.uniklinikum-dresden.de/oupc

Anhang

Pressemitteilung

(nach oben)

Braunalgenschleim ist gut fürs Klima

Dr. Fanni Aspetsberger Presse- und Öffentlichkeitsarbeit

Max-Planck-Institut für Marine Mikrobiologie

Braunalgen nehmen große Mengen Kohlendioxid aus der Luft auf und geben Teile des enthaltenen Kohlenstoffs in Form eines schwer abbaubaren Schleims wieder an die Umwelt ab. Weil dieser Schleim kaum einem Meeresbewohner schmeckt, verschwindet dieser Kohlenstoff so für lange Zeit aus der Atmosphäre. Das zeigt eine Studie von Forschenden des Max-Planck-Instituts für Marine Mikrobiologie in Bremen. Die Forschenden zeigen, dass insbesondere der Algenschleim namens Fucoidan dafür verantwortlich ist und schätzen, dass Braunalgen so bis zu 550 Millionen Tonnen Kohlendioxid jedes Jahr aus der Luft holen könnten – beinahe die Menge der gesamten jährlichen Treibhausgas-Emissionen Deutschlands.

Braunalgen sind wahre Superpflanzen wenn es darum geht, Kohlendioxid aus der Luft aufzunehmen. Sie übertreffen darin sogar die Wälder an Land und spielen deswegen eine entscheidende Rolle für die Atmosphäre und unser Klima. Aber was passiert mit dem Kohlendioxid, nachdem die Algen es aufgenommen haben? Nun berichten Forschende des Max-Planck-Instituts für Marine Mikrobiologie in den Proceedings der amerikanischen National Academy of Sciences (PNAS), dass die Braunalgen große Mengen an Kohlendioxid langfristig aus dem globalen Kreislauf entfernen und so der Klimaerwärmung entgegenwirken können.Fucoidan: Die wenigsten mögen Braunalgenschleim

Fucoidan: Die wenigsten mögen Braunalgenschleim

Algen nehmen Kohlendioxid aus der Luft auf und nutzen den darin enthaltenen Kohlenstoff für ihr Wachstum. Bis zu einem Drittel des aufgenommenen Kohlenstoffs geben sie wieder ans Meerwasser ab, beispielsweise in Form zuckerhaltiger Ausscheidungen. Je nachdem, wie diese Ausscheidungen aufgebaut sind, werden sie entweder schnell von anderen Organismen genutzt oder sinken Richtung Meeresgrund.

„Die Ausscheidungen der Braunalgen sind sehr komplex und daher unglaublich kompliziert zu messen“, sagt Erstautor Hagen Buck-Wiese vom Max-Planck-Institut für Marine Mikrobiologie in Bremen. „Es ist uns aber gelungen, eine Methode zu entwickeln, um sie detailliert zu analysieren.“ Die Forschenden nahmen eine Vielzahl verschiedener Substanzen unter die Lupe. Als besonders spannend entpuppte sich dabei das sogenannte Fucoidan. „Fucoidan machte etwa die Hälfte der Ausscheidungen der von uns untersuchten Braunalgenart namens Blasentang aus“, so Buck-Wiese. Zudem ist Fucoidan sehr widerständig. „Das Fucoidan ist so komplex, dass es nur schwer für andere Organismen nutzbar ist. Keiner scheint es zu mögen.“ So kommt es, dass der Kohlenstoff im Fucoidan nicht so schnell wieder in die Atmosphäre gelangt. „Die Braunalgen sind dadurch besonders gute Helfer, um Kohlendioxid langfristig – für Hunderte bis Tausende von Jahren – aus der Atmosphäre zu entfernen.“

Braunlagen könnten fast den gesamten Kohlendioxid-Ausstoß Deutschlands binden

Braunalgen sind außergewöhnlich produktiv. Es wird geschätzt, dass sie etwa 1 Gigatonne (eine Milliarde Tonnen) Kohlenstoff pro Jahr aus der Luft aufnehmen. Rechnet man nun mit den Ergebnissen der vorliegenden Studie, ergibt sich, dass dadurch bis zu 0,15 Gigatonnen Kohlenstoff, was 0,55 Gigatonnen Kohlendioxid entspricht, jedes Jahr langfristig durch die Braunalgen gebunden werden. Zum Vergleich: Die jährlichen Treibhausgas-Emissionen Deutschlands belaufen sich laut Umweltbundesamt aktuell auf etwa 0,75 Gigatonnen Kohlendioxid (Schätzung für 2020).

„Was die Sache noch besser macht: Im Fucoidan sind keine Nährstoffe wie beispielsweise Stickstoff enthalten“, erklärt Buck-Wiese weiter. Das Wachstum der Braunalgen wird durch die Kohlenstoffverluste also nicht beeinträchtigt.

Weitere Arten und Orte

Für die aktuelle Studie konnten Buck-Wiese und seine Kolleginnen und Kollegen aus der MARUM MPG Brückengruppe Marine Glykobiologie, die sowohl am Bremer Max-Planck-Institut als auch am MARUM – Zentrum für Marine Umweltwissenschaften der Universität Bremen angesiedelt ist, ihre Experimente an der Tvärminne Zoological Station in Südfinnland durchführen. „Als nächstes wollen wir schauen, wie es bei anderen Braunalgenarten und an anderen Standorten aussieht“, sagt Buck-Wiese. „Das große Potenzial der Braunalgen für den Klimaschutz gilt es unbedingt weiter zu erforschen und zu nutzen.“

Wissenschaftliche Ansprechpartner:

Hagen Buck-Wiese

MARUM MPG Brückengruppe Marine Glykobiologie

Max-Planck-Institut für Marine Mikrobiologie, Bremen

Telefon: +49 421 2028-7360

E-Mail: hbuck@mpi-bremen.de

Dr. Jan-Hendrik Hehemann

MARUM MPG Brückengruppe Marine Glykobiologie

Max-Planck-Institut für Marine Mikrobiologie, Bremen

Telefon: +49 421 218-65775

E-Mail: jheheman@mpi-bremen.de

Dr. Fanni Aspetsberger

Pressereferentin

Max-Planck-Institut für Marine Mikrobiologie, Bremen

Telefon: +49 421 2028-9470

E-Mail: presse@mpi-bremen.de

Originalpublikation:

Hagen Buck-Wiese, Mona A. Andskog, Nguyen P. Nguyen, Margot Bligh, Eero Asmala, Silvia Vidal-Melgosa, Manuel Liebeke, Camilla Gustafsson, Jan-Hendrik Hehemann (2022): Fucoid brown algae inject fucoidan carbon into the ocean. PNAS (December 2022).

Weitere Informationen:

https://www.mpi-bremen.de/Page5921.html

(nach oben)

TV-Doku: FH-Student beleuchtet Lichtverschmutzung

Michael Milewski Presse- und Öffentlichkeitsarbeit

Fachhochschule Dortmund

Für seine Bachelor-Abschlussarbeit hat sich FH-Fotografie-Student Oskar Schlechter mit „Lichtverschmutzung“ in Städten beschäftigt und ein 160-seitiges Fotobuch mit dem Titel „Darkless“ gestaltet. Die Dokumentation „Die Macht der Nacht“ zeigt den 29-Jährigen jetzt aktuell mit seinem Schaffen in der Mediathek des TV-Senders „arte“.

Gleich zum Auftakt der neuen Ausgabe der Kulturreihe „TWIST“ sind nicht nur Aufnahmen zu sehen, die Oskar Schlechter bei seinen nächtlichen Exkursionen gemacht hat. Auch er selbst steht vor der TV-Kamera und erläutert Probleme, die sich aus dem „Lichtsmog“ ergeben – wenn die Nacht quasi künstlich zum Tag gemacht wird, also Naturgesetze außer Kraft gesetzt werden und darunter beispielsweise der Biorhythmus von Menschen, Tieren und Pflanzen leidet.

„Meine Arbeit soll eine Anregung sein, in den jeweiligen Situationen darüber nachzudenken: Braucht man das Licht wirklich?“, sagt Oskar Schlechter. „Muss die Beleuchtung tatsächlich in allen Räumen aktiviert sein? Und wie ist es im Garten?“, nennt er Beispiele für Privatleute. Weitere Beispiele im öffentlichen Raum seien Laternen, leuchtende Werbedisplays oder angestrahlte Bauwerke. „Damit sollten sich die Verantwortlichen auch unabhängig von der derzeitigen Energiekrise beschäftigen.“

Für sein Fotobuch, das 2023 in den Druck gehen soll, porträtierte Oskar Schlechter auch Menschen, die sich in ihrem Alltag oder beruflich mit der übermäßigen nächtlichen Beleuchtung auseinandersetzen, darunter ein Lichtforscher. Betreuer der Abschlussarbeit waren Prof. Dr. Marcel Marburger und Prof. Kai Jünemann vom Fachbereich Design der Fachhochschule Dortmund.

Wissenschaftliche Ansprechpartner:

Prof. Dr. Marcel Marburger

Fachhochschule Dortmund / Fachbereich Design

Mail: MarcelRene.Marburger@fh-dortmund.de

Prof. Kai Jünemann

Fachhochschule Dortmund / Fachbereich Design

Mail: kai.juenemann@fh-dortmund.de

Weitere Informationen:

https://www.fh.do/nacht Link zur Dokumentation „Die Macht der Nacht“

(nach oben)

Grünen Wasserstoff effizient produzieren: BMBF fördert deutsch-kanadisches Verbundprojekt an der Universität Bayreuth

Christian Wißler Pressestelle

Universität Bayreuth

Die Effizienz und Zuverlässigkeit von Elektrolyseanlagen zu steigern, ist das Ziel eines neuen internationalen Verbundprojekts am Zentrum für Energietechnik (ZET) der Universität Bayreuth. Gemeinsam mit einem deutschen Industriepartner und vier kanadischen Partnern aus Industrie und Wissenschaft werden neuartige Modelle sowie Hard- und Softwareanwendungen zur Kostensenkung bei der Produktion von grünem Wasserstoff entwickelt. Das Bundesministerium für Bildung und Forschung (BMBF) fördert das Vorhaben für drei Jahre, die Universität Bayreuth erhält insgesamt rund 250.000 Euro.

Grüner Wasserstoff hat in zukünftigen Energiesystemen eine Schlüsselfunktion bei der Dekarbonisierung und der Kopplung aller Sektoren. Die Europäische Union hat sich daher das Ziel gesetzt, bis 2030 in den eigenen Mitgliedsländern zehn Millionen Tonnen grünen Wasserstoff zu produzieren und weitere zehn Millionen Tonnen zu importieren. Dies kann nur gelingen, wenn dafür effiziente, zuverlässige und wettbewerbsfähige Technologien zur Verfügung stehen. Besonders geeignet zur Produktion von grünem Wasserstoff im großen Maßstab sind Elektrolyseanlagen, deren Funktionsweise auf der Protonen-Austausch-Membran (PEM) basiert. Diese PEM-Elektrolyseanlagen werden bereits im Megawatt-Maßstab kommerziell eingesetzt. Sie bieten schnelle Reaktionszeiten und können sehr flexibel betrieben werden. Dadurch kann die stark fluktuierende Stromerzeugung aus nachhaltigen Energiequellen wie Sonne oder Wind direkt mit PEM-Elektrolyseanlagen gekoppelt werden. Diese große Dynamik kann jedoch dazu führen, dass die zu Stacks zusammengefassten Elektrolysezellen vorzeitig altern. Infolgedessen verringern sich auch die Lebensdauer und die Leistung der Anlage insgesamt. Bisher ist es nicht möglich, diese Prozesse im industriellen Maßstab abhängig von der Betriebsweise vorherzusagen: Die an der Elektrolyse beteiligten Vorgänge sind komplex und die Langzeit-Betriebserfahrungen gering.

Genau hier setzt das vom BMBF geförderte deutsch-kanadischen Verbundprojekt „Modellentwicklung zur Steigerung der Effizienz von Elektrolyseanlagen“ (kurz: „Hyer“) an. Gemeinsam wollen die Forschungspartner ein digitales techno-ökonomisches Modell einer PEM-Elektrolyseanlage entwickeln, die mit erneuerbaren Energiesystemen gekoppelt ist und sich durch eine dynamische Betriebsweise auszeichnet. In Verbindung mit Hard- und Softwareanwendungen wird dieses Modell es ermöglichen, Alterungsvorgänge und die Verringerung der Leistungsfähigkeit mit hoher Genauigkeit vorherzusagen. Dadurch können Betriebsstrategien unter Berücksichtigung der Lebensdauer optimiert werden. Das angestrebte Modell wird dazu auch den digitalen Zwilling eines Stacks umfassen, der die nachteiligen Folgen einer dynamischen Betriebsweise für die Elektrolysezellen präzise abbildet.

An der Entwicklung des digitalen Zwillings werden Forschende des Institute for Integrated Energy Systems an der University of Victoria und des National Research Council Canada (NRC) mit Methoden der künstlichen Intelligenz und des maschinellen Lernens arbeiten. Die zur Modellierung notwendigen experimentellen Daten werden vom Hydrogen Research Institute der Université du Québec à Trois-Rivières bereitgestellt, das in Zusammenarbeit mit dem NRC neuartige Stacks herstellt, analysiert und charakterisiert. Diese Stacks werden in einem speziell für das Projekt „Hyer“ entwickelten Prüfstand bei der SEGULA Technologies GmbH in Rüsselsheim getestet und beschleunigt gealtert. Für die elektrochemische Charakterisierung der Stacks wird das in Toronto ansässige Start-up Pulsenics Inc. die erforderlichen technischen Lösungen liefern.

Unter der der Leitung von Prof. Dr.-Ing. Dieter Brüggemann, Direktor des ZET, übernimmt das Bayreuther Team die techno-ökonomische Simulation und Optimierung der PEM-Elektrolyseanlage. „Unser Ziel ist es, einen guten Kompromiss zwischen einer langen Lebensdauer und einer hohen Flexibilität der Elektrolyseanlage zu finden. Von dem Modell werden beispielsweise auch Projektentwickler und Anlagenbetreiber profitieren, da es durch datengestützte Regelungs- und Betriebsstrategien einen vorhersehbaren kostenoptimierten Anlagenbetrieb ermöglicht“ sagt Brüggemann und betont die starke internationale und interdisziplinäre Zusammenarbeit im neuen Verbundprojekt: „Die langjährige deutsch-kanadische Partnerschaft in Wissenschaft, Technologie und Innovation hat mit der aktuellen Energiekrise noch mehr an Bedeutung gewonnen. Beide Länder ergänzen sich optimal in ihren Zielsetzungen, den Klimawandel zu begrenzen, was nicht zuletzt an der Gründung der deutsch-kanadischen Wasserstoffallianz sichtbar wird. Im Projekt bringen die Partner ihre Expertisen auf verschiedensten Fachgebieten ein – von der Materialforschung bis hin zur Simulation von Energiesystemen mit neuesten Methoden. Dadurch können Lösungen entwickelt werden, die ohne diesen Austausch nicht möglich wären.“

Matthias Welzl, der als Koordinator für Wasserstoffforschung und -technologien das Projekt am ZET wesentlich vorbereitet hat, übernimmt die Koordination der deutschen Projektpartner. Er ergänzt: „Seit über einem Jahr arbeiten wir gemeinsam intensiv an der Ausgestaltung des Projekts. Dabei entwickelte sich insbesondere mit den beiden Projektverantwortlichen unserer Industriepartner, Mariam Awara und Dr. Ing. Stephan Wagner, ein enger Kontakt.“ Mariam Awara ist COO und Mitgründerin des kanadischen Start-up Pulsenics Inc., dessen elektrochemisches Monitoring- und Regelungssystem Grundlage für die Umsetzung des Projekts ist. Für die erfolgreiche Gründung von Pulsenics Inc. wurde sie 2022 in der Kategorie „Manufacturing & Industry“ auf der „Forbes 30 Under 30“-Liste ausgezeichnet. Stephan Wagner wird als Projektingenieur und Experte für Wasserstofftechnologien die Arbeiten bei der SEGULA Technologies GmbH leiten. Welzl beschreibt die weiteren Planungen: „Demnächst werden wir nach Kanada reisen, um auch die anderen Partner persönlich kennenzulernen und die Projektarbeit mit einem Kickoff-Workshop offiziell zu starten.“

Wissenschaftliche Ansprechpartner:

Prof. Dr.-Ing. Dieter Brüggemann

Direktor des Zentrums für Energietechnik (ZET)

Universität Bayreuth

Telefon: +49 (0)921 / 55-7160

E-Mail: brueggemann@uni-bayeuth.de

Matthias Welzl, M.Sc.

Koordinator Wasserstoffforschung und -technologien

Akad. Rat am Zentrum für Energietechnik (ZET)

Universität Bayreuth

Telefon: +49 (0)921 / 55-7525

E-Mail: matthias.welzl@uni-bayreuth.de

(nach oben)

Seltene Bakterien sind hauptverantwortlich für den Kohlenstoffkreislauf im Meer

Alexandra Frey Öffentlichkeitsarbeit

Universität Wien

Rare Bakterienarten sind im Ozean am aktivsten, häufige Arten hingegen sind weniger aktiv

Ein internationales Team aus Meeresbiolog*innen mit Beteiligung von Gerhard J. Herndl und Eva Sintes von der Universität Wien hat eine Methode entwickelt, die es erlaubt die Atmungsaktivität von einzelnen Bakterienarten zu bestimmen. Dabei fanden sie heraus, dass im offenen Ozean weniger häufige Bakterienarten die größten Atmungsraten haben, also mehr Sauerstoff verbrauchen und CO2 produzieren. Jene Bakterien hingegen, die besonders häufig im Ozean zu finden sind, verbrauchen eine relativ geringe Menge an organischem Material. Weniger als 3% der Bakterien im Ozean konsumieren so ein Drittel des gesamten Sauerstoffs. Diese Ergebnisse haben große Auswirkungen auf die Sichtweise auf den Kohlenstoffkreislauf der Ozeane und erscheinen aktuell im renommierten Fachjournal „Nature“.

Häufig ist nicht gleich wichtig

In einem Liter Ozeanwasser finden sich hunderttausende verschiedene Bakterienarten. Die meisten dieser Bakterien veratmen, so wie wir, Sauerstoff, um Energie aus organischem Material zu gewinnen und erzeugen dabei Kohlendioxid. Um abzuschätzen, wie hoch die Atmungsaktivität von Meeresmikroben ist, haben Forscher*innen bisher die Summe die gesamte Atmungsaktivität durch die Anzahl der vorhandenen Organismen geteilt. Dieser Ansatz berücksichtigt jedoch nicht die überwältigende Artenvielfalt der verschiedenen Meeresbakterien, die nicht alle die gleiche Atmungsaktivität haben.

Die im Fachjournal Nature publizierte Studie zeigt nun, dass die Unterschiede zum Teil gravierend sind: „Die Atmungsaktivität der einzelnen Bakterienarten im Meerwasser kann bis zu tausendfach variieren. Wir haben herausgefunden, dass gerade jene Bakterien, die im Ozean weniger zahlreich vertreten sind die höchsten Atmungsaktivitäten zeigen, während sehr häufig vorkommende Bakterien geringe Atmungsaktivitäten haben“, erklärt Gerhard J. Herndl von der Universität Wien, einer der Co-Autor*innen der internationalen Studie. Das bedeutet, dass für den Kohlenstoffkreislauf in den Meeren die seltenen Bakterien insgesamt wichtiger sind als die Mikroorganismen, die in großer Anzahl im Meerwasser vorkommen. „Das ist ein häufiges Missverständnis in der Ökologie und in der Betrachtung der biogeochemischen Kreisläufe. Nicht jene Organismengruppen oder Nährstoffe, die in der höchsten Konzentration verkommen, sind besonders wichtig, sondern sehr oft jene, die nur in geringen Konzentrationen vorkommen“, erklärt Herndl.

Neue Methode verbindet die Messung der Atmungsaktivität mit mikrobieller DNA

Um die komplexe Gemeinschaft der Mikroorganismen im Ozean zu verstehen, entwickelte das internationale Team eine neue Methode, mit der sie die Atmungsaktivität und den genetischen Code einzelner Zellen verknüpfen können. Dabei verwendeten die Forscher*innen zuerst fluoreszierende Sonden, um die Atmungsraten einzelner Bakterienzellen zu messen. Je mehr eine Zelle atmet, desto mehr fluoresziert sie. Das Fluoreszenzsignal wird gemessen und die Zellen werden gleichzeitig nach ihrer Fluoreszenz sortiert. Anschließend werden die einzelnen Zellen einer genetischen Analyse unterzogen, um herauszufinden, um welche Art es sich handelt. Für die Studie wurden Bakteriengemeinschaften aus dem Golf von Maine, dem Mittelmeer und aus dem offenen Atlantischen und Pazifischen Ozean untersucht.

Bakterien und der Kohlenstoffkreislauf im Meer

Bakterien, die organisches Material wieder in anorganische Komponenten, wie etwa CO2 umwandeln, dominieren den Kohlenstoffkreislauf im Meer und setzen mehr organisches Material um, als all die anderen Lebewesen im Meer zusammen. Sie spielen also eine große Rolle im ozeanischen Kohlenstoffkreislauf und deshalb ist es außerordentlich wichtig, ihre Atmung als Aktivitätsparameter zu messen: „Wenn nun die meisten Bakterien im Meer nur wenig aktiv sind, so wie unsere Studie zeigt, dann heißt das, dass wenige Bakterienarten sehr hohe Stoffumsetzungsraten haben. Gleichzeitig werden diese hochaktiven Bakterien aber offensichtlich stark beweidet, das heißt von anderen Lebewesen gefressen, sodass sie nur in geringen Häufigkeiten vorkommen. Hohe Aktivität bedeutet also auch hohe Verlustraten durch Beweidung. Das bedeutet wiederum, dass nur wenige Bakterienarten dafür sorgen, dass wir einen hohen Kohlenstofffluss haben, während der Großteil der Bakterien eher wenig aktiv ist, langsam wächst und auch wenig beweidet wird. Diese neuen Erkenntnisse haben große Auswirkungen auf die Untersuchung von globalen Nährstoffkreisläufen wie dem Kohlenstoffkreislauf, da das Meer für einen Großteil des globalen Kohlenstoffkreislaufes verantwortlich ist.“, so Gerhard J. Herndl.

Wissenschaftliche Ansprechpartner:

Gerhard J. Herndl

Department für Funktionelle und Evolutionäre Ökologie

Universität Wien

1030 Wien, Djerassiplatz 1

T +43-1-4277-76431

M +43-664-817-5971

gerhard.herndl@univie.ac.at

chie.amano@univie.ac.at

Originalpublikation:

„Decoupling of respiration rates and abundance in marine Prokaryoplankton“: Jacob H. Munson-McGee, Melody R. Lindsay, Julia M. Brown, Eva Sintes, Timothy D’Angelo, Joe Brown, Laura C. Lubelczyk, Paxton Tomko, David Emerson, Beth N. Orcutt, Nicole J. Poulton, Gerhard J. Herndl, Ramunas Stepanauskas. Nature

doi: 10.1038/s41561-022-01081-3

https://www.nature.com/articles/s41586-022-05505-3

(nach oben)

Hochbelastbar und biologisch abbaubar

Helena Dietz Stabsstelle Kommunikation und Marketing

Universität Konstanz

Ein Polyester-Kunststoff mit hoher mechanischer Stabilität, der trotzdem gut recycelt werden kann und sogar kompostierbar ist: Forschende der Universität Konstanz um den Chemiker Stefan Mecking stellen ein neues Material vor.

Wie können Kunststoffe so gestaltet werden, dass ihre positiven Materialeigenschaften erhalten bleiben, sie aber gleichzeitig besser rezykliert werden können? Diese und andere Fragen zur Umweltverträglichkeit von Kunststoff-Materialien erforscht der Chemiker Stefan Mecking in seiner Arbeitsgruppe an der Universität Konstanz. In ihrem aktuellen Artikel in der internationalen Ausgabe der Fachzeitschrift Angewandte Chemie stellt die Arbeitsgruppe nun einen neuen Polyester vor, der industriell gefragte Materialeigenschaften und gute Umweltverträglichkeit in einem Kunststoff vereint.

Normalerweise kaum vereinbar

Kunststoffe bestehen aus langen Aneinanderkettungen eines oder weniger chemischer Grundbausteine, sogenannter Monomere. Kunststoffe, die sich durch eine hohe Kristallinität und einen wasserabweisenden Charakter auszeichnen und dadurch mechanisch hochbelastbar und beständig sind, sind weit verbreitet. Ein bekanntes Beispiel ist hochdichtes Polyethylen (HDPE), dessen Grundbausteine unpolare Kohlenwasserstoffmoleküle sind. Was auf der einen Seite vorteilhaft für die Anwendungseigenschaften sein kann, birgt jedoch auch Nachteile: Das Recycling derartiger Kunststoffe – also die Rückgewinnung der Grundbausteine – ist sehr energieaufwändig und ineffizient. Gelangen die Kunststoffe unbeabsichtigt in die Umwelt, werden sie dort nur extrem langsam abgebaut.